-

Conversational AI / NLPMegatron-LM を用いた日本語に強い 172B 大規模言語モデルの開発

-

Generative AINVIDIA NeMo による最先端のマルチモーダル生成 AI モデル開発

-

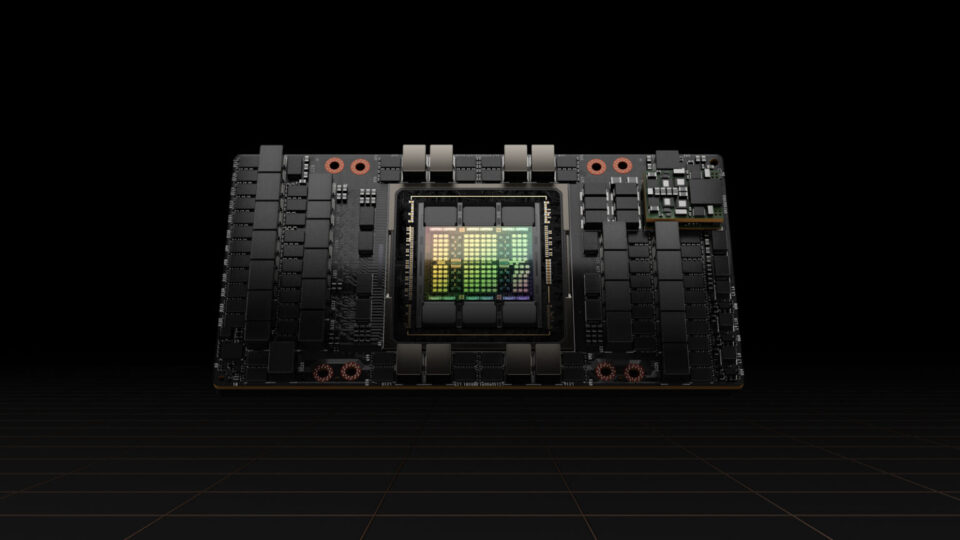

Data Center / Cloud / EdgeNVIDIA GH200 Superchip が、Llama モデルとのマルチターン インタラクションの推論を 2 倍高速化

-

Generative AI先進的なソブリン AI モデルが、日本のイノベーションとチャンスを解き放つ

-

Conversational AI / NLP高速化された Llama 3.2 をエッジからクラウドへデプロイする

最近の投稿

2025 年 1 月 20 日

NeMo Framework で実践する継続事前学習 - 日本語 LLM 編 -

フルスクラッチに比べ、少量のデータでもモデルを新しい言語やタスクに効果的に適応させることができる継続事前学習を実行する方法を、NeMo Framework を使用して解説します。

3 MIN READ

2024 年 12 月 17 日

NeMo Curator を使った日本語テキスト データのドメイン分類

NeMo Curator は、日本のソブリン LLM の構築や更新のためのデータセットを準備するために、日本語をサポートする多言語ドメイン分類器をリリースしました。

3 MIN READ

2024 年 12 月 11 日

NVIDIA AI Blueprint でカスタマー サービス向けの AI バーチャル アシスタントを作成する 3 つの構成要素

NIM と NeMo™ Retriever を活用したリファレンス アプリケーションである NVIDIA NIM™ AI Blueprint を使用して、あらゆる業界のカスタマー サービスを変革しましょう。

2 MIN READ

2024 年 11 月 22 日

Hymba ハイブリッド ヘッド アーキテクチャが小規模言語モデルのパフォーマンスを向上

Hymba 1.5B は、同様の規模である最先端のオープンソース モデルと比べ、良好なパフォーマンスを発揮し、同等のサイズの Transformer モデルで比較すると、Hymba はより高いスループットを発揮し、キャッシュを保存するために必要なメモリが 10 分の 1 で済みます。

4 MIN READ

2024 年 11 月 21 日

NVIDIA NIM でファインチューニングされた AI モデルのデプロイ

パフォーマンスを最適化した TensorRT-LLM 推論エンジンをローカルでビルドして、SFT でカスタマイズされたモデルに対する NIM マイクロサービスを迅速にデプロイする方法を説明します。

2 MIN READ

2024 年 11 月 13 日

LLM テクニックの習得: データの前処理

LLM の精度向上におけるデータ品質は重要であり、さまざまなデータ処理手法があります。NeMo Curator を利用して今すぐ課題に対処してみましょう。

2 MIN READ

2024 年 11 月 13 日

2D と 3D のデジタル ヒューマン アバターによる AI エージェント インターフェイス オプションの拡張

さまざまなユース ケースに合わせてカスタマイズすることができる、カスタマー サービス向けデジタル ヒューマンの NVIDIA AI Blueprint は、リアルなデジタル ヒューマンの作成を始めるのに最適です。

2 MIN READ

2024 年 11 月 11 日

Megatron-LM を用いた日本語に強い 172B 大規模言語モデルの開発

日本のモデル開発を促進するためのプロジェクトである GENIAC に採択された LLM-jp が、NVIDIA Megatron-LM を使用して、日本語に強い 172B オープンモデルの学習を高速化しました。

2 MIN READ

2024 年 11 月 8 日

NeMo Framework で日本語 LLM をファインチューニング - DPO 編 -

NeMo Framework を使用して、日本語の大規模言語モデル (LLM) で、人間の嗜好や価値観に沿うようにモデルを調整するアライメント手法の一つである、DPO (Direct Preference Optimization) を実行する方法を説明します。

4 MIN READ

2024 年 11 月 8 日

NVIDIA TensorRT-LLM の KV Cache Early Reuseで、Time to First Token を 5 倍高速化

KV キャッシュの再利用技術と、TTFT のさらなる高速化を実現するベストプラクティスについて解説します。

2 MIN READ

2024 年 11 月 6 日

NVIDIA NeMo による最先端のマルチモーダル生成 AI モデル開発

NeMo Curator を使用した大規模なデータ処理と、Cosmos トークナイザーを使用した高品質なトークン化やビジュアル再構築を備えた、NVIDIA NeMo プラットフォームで、最先端のマルチモーダル生成 AI モデルを構築しましょう。

2 MIN READ

2024 年 11 月 4 日

NVIDIA AI Workbench によるハイブリッド環境におけるスムーズなコラボレーションと迅速なプロトタイピング

データ サイエンス、AI、機械学習などのプロジェクトを合理化する無料の開発環境マネージャー「NVIDIA AI Workbench」の、最新リリースでの主要な新機能とユーザーから要望のあった更新についてご紹介します。

3 MIN READ

おすすめ

2024 年 11 月 22 日

Hymba ハイブリッド ヘッド アーキテクチャが小規模言語モデルのパフォーマンスを向上

Hymba 1.5B は、同様の規模である最先端のオープンソース モデルと比べ、良好なパフォーマンスを発揮し、同等のサイズの Transformer モデルで比較すると、Hymba はより高いスループットを発揮し、キャッシュを保存するために必要なメモリが 10 分の 1 で済みます。

4 MIN READ

2024 年 11 月 8 日

NVIDIA TensorRT-LLM の KV Cache Early Reuseで、Time to First Token を 5 倍高速化

KV キャッシュの再利用技術と、TTFT のさらなる高速化を実現するベストプラクティスについて解説します。

2 MIN READ

2024 年 10 月 31 日

NVIDIA NIM によるマルチモーダル ビジュアル AI エージェントの構築

NVIDIA NIM マイクロサービスを使用すれば、高度なビジュアル AI エージェントの構築がこれまで以上に簡単で効率的になります。

3 MIN READ

2024 年 10 月 28 日

LLM のモデル マージのご紹介

複数のカスタマイズされた LLM の重みを組み合わせることで、リソースの利用率を高めるモデル マージの、機能方法、種類、およびモデル マージがどのように繰り返され、進化しているのかについてご紹介します。

2 MIN READ

2024 年 10 月 8 日

NVIDIA cuOpt で大規模な線形計画問題を加速する

NVIDIA cuOpt は現在、GPU アクセラレーションで PDLP を実装しています。最先端のアルゴリズム、NVIDIA ハードウェア、専用の CUDA 機能、NVIDIA GPU ライブラリを使用して、cuOpt LP ソルバーは、CPU ベースのソルバーと比較して 5,000 倍以上の高速パフォーマンスを実現しています。

3 MIN READ

2024 年 9 月 30 日

NVIDIA NIM Operator で Kubernetes の AI 推論パイプラインを管理

NIM Operator を使用すれば、わずか数回のクリックまたはコマンドで、NVIDIA NIM マイクロサービスのデプロイ、オートスケーリング、ライフサイクルを管理することができます。

2 MIN READ

2024 年 9 月 25 日

高速化された Llama 3.2 をエッジからクラウドへデプロイする

NVIDIA のアクセラレーテッド コンピューティング プラットフォームと組み合わせることで、Llama 3.2 は開発者、研究者、企業に、生成 AI のユース ケースを実現するための有益な新機能と最適化を提供します。

2 MIN READ

2024 年 9 月 23 日

Llama-3.1-Nemotron-51B による精度と効率の前進

NVIDIA は、比類のない精度と効率を実現する独自の言語モデル、Llama 3.1-Nemotron-51B を発表しました。 Meta の Llama-3.1-70B の派生モデルであり、新しい Neural Architecture Search (NAS) アプローチによる、高精度かつ効率的なモデルです。

3 MIN READ

2024 年 6 月 28 日

NVIDIA NIM による財務分析の変革

金融サービスでは、ポートフォリオ マネージャーやリサーチ アナリストが膨大な量のデータを丹念に精査し、投資で競争力を高めています。

4 MIN READ

2024 年 4 月 2 日

NVIDIA TensorRT-LLM による、LoRA LLM のチューニングとデプロイ

LLM のトレーニング コストを抑え、そのパワーを活用可能なファインチューニングの手法の 1 つである、Low-Rank Adaptation (LoRA) の洞察力と実装について説明し、その応用と利点の一部をご紹介します。

7 MIN READ

2024 年 3 月 20 日

記録を塗り替え続ける NVIDIA cuOpt アルゴリズムがルート最適化ソリューションを 100 倍高速化

最適化アルゴリズムの主要な要素、その定義、業界をリードするソリューションに対して NVIDIA cuOpt のベンチマークを実行するプロセスについて掘り下げ、その比較の重要性に焦点を当ててご紹介します。

3 MIN READ

2024 年 3 月 18 日

NVIDIA GB200 NVL72 は兆単位パラメーターの LLM トレーニングとリアルタイム推論を実現

新しい NVIDIA GB200 NVL72 は、計算負荷が高く、リソースを大量に消費する大規模なモデルのトレーニングとデプロイに対応するシステムの 1 つです。

4 MIN READ