NVIDIA AI 推理管理器 SDK

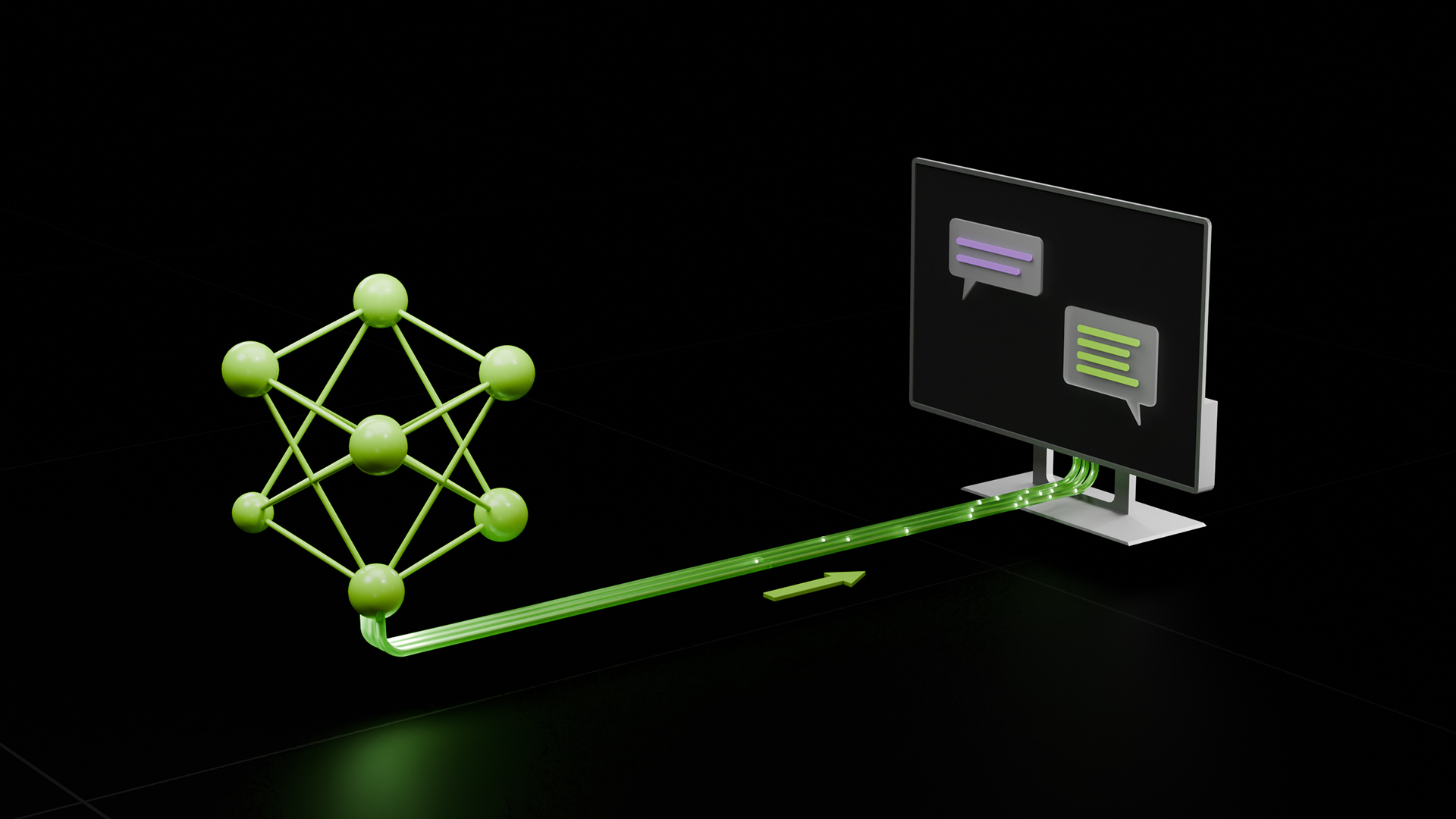

NVIDIA AI 推理管理器 (AIM) SDK 简化了 PC 应用程序开发者的 AI 模型部署和集成。该 SDK 预先配置了 PC 上所需的 AI 模型、引擎和依赖项。它通过统一的推理 API 在 PC 和云之间无缝编排 AI 推理。此外,它还支持跨不同硬件加速器 (GPU、NPU、CPU) 的所有主要推理后端。AIM SDK 现已提供抢先体验版。NVIDIA AI 推理管理器 (AIM) 软件开发套件 (SDK)

产品概述

在整个 PC 生态系统中提供优化的 AI 赋能用户体验可能十分复杂。开发者需要在不同类型的设备中管理模型、库和依赖项,并在设备资源有限时切换到云端。AIM 可以轻松将 AI 模型集成到应用程序中,并在云和 PC 之间编排部署。

应用程序部署

执行硬件兼容性验证,并在用户设备上管理模型、引擎和运行时依赖项的安装和配置过程。轻松定义应用特定策略,以便在云和本地 PC 上进行编排。

多个推理后端

使用您选择的后端 (无论是 DirectML、TensorRT、Llama.cpp、PyTorch-CUDA 还是自定义后端),在终端用户设备上优化和运行模型。

本地和云端执行

AIM SDK 支持任何云 API 端点,包括 NVIDIA NIM,以及 PC 上的本地执行。对于本地执行,开发者可以使用进程内执行方法直接集成到延迟敏感型应用程序,或者使用进程外执行方法集成到应用程序中作为服务。

集成到图形管线

提供原生集成到游戏制作流程的功能,并能够实现低延迟的 CUDA 和图形执行。

优势

灵活性

AIM 采用模块化方式构建,具有 C++插件,可为开发者提供完全的灵活性,以便为用户设计应用程序特定的体验。AIM 的模块化特性使开发者能够选择感兴趣的推理后端,配置自定义执行策略等。

易用性

轻松将 AI 功能部署到应用程序中,无需担心终端用户系统上的安装流程、模型、引擎和运行时依赖项管理。

跨平台扩展

横跨数千个终端用户系统配置,包括不同的加速器 (GPU、NPU 和 CPU),同时通过 AI 模型的云或本地 PC 部署提供出色的用户体验。

相关产品

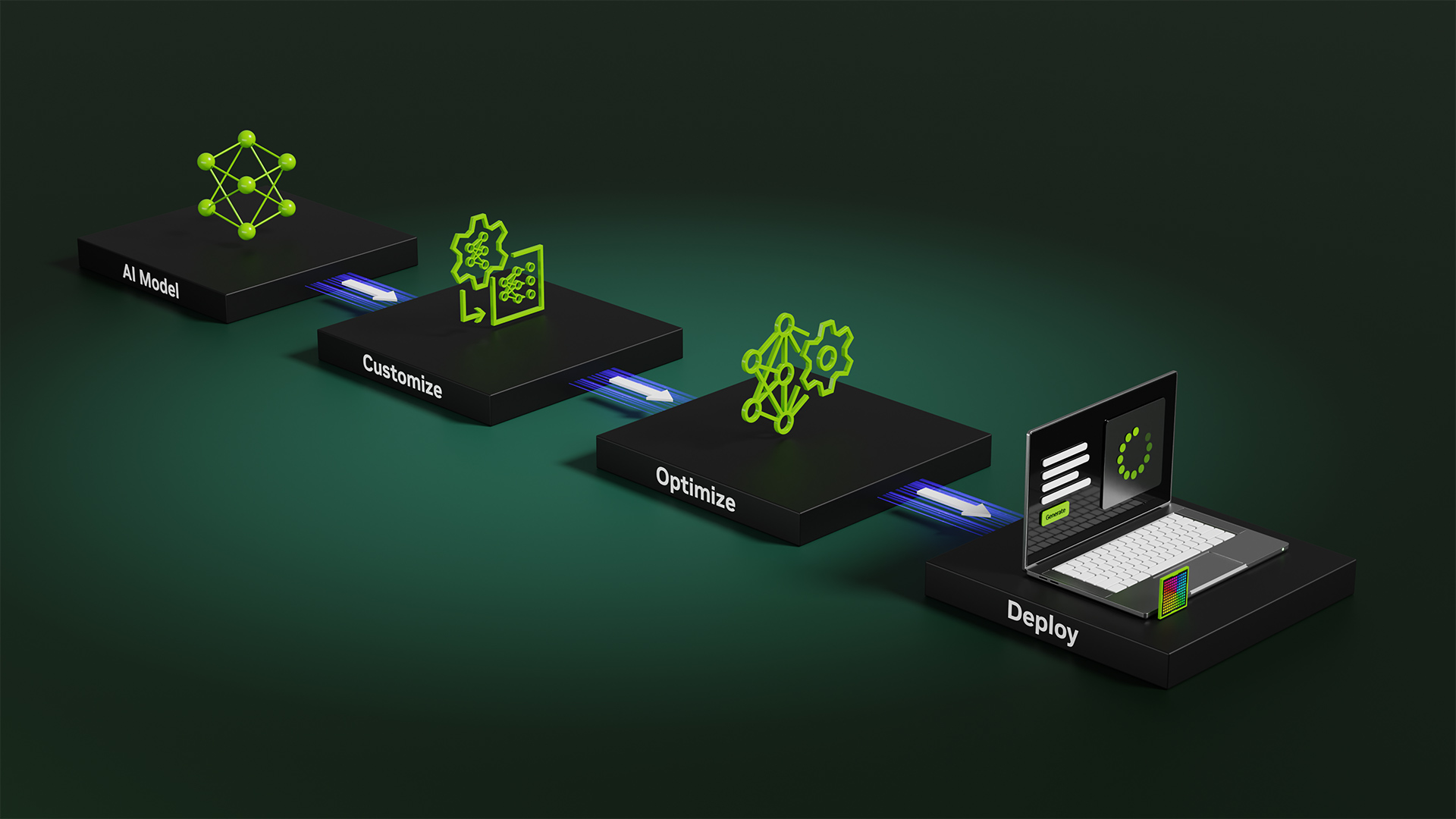

RTX AI 工具套件

适用于 Windows 开发者的一套工具,用于在 RTX PC 和云端加速 AI 模型的自定义、优化和部署。

NVIDIA ACE

NVIDIA ACE 是一套 NIM,可帮助开发者借助生成式 AI 让数字人栩栩如生。

资源

AIM 目前作为抢先体验计划的一部分提供给开发者。