面向开发者的生成式 AI

生成式 AI 引入了新一波开发者工具、框架和应用。不断扩大的生态系统有助于训练大规模的多模态模型、针对用例进行微调、从数据中心到最小的嵌入式设备进行量化和部署。构建生成式 AI 应用程序的开发者需要具有从芯片和系统软件到加速库和应用开发框架的全栈优化的加速计算平台。借助 NVIDIA 托管的模型 API 和预构建的推理微服务,您可以随时随地部署模型。

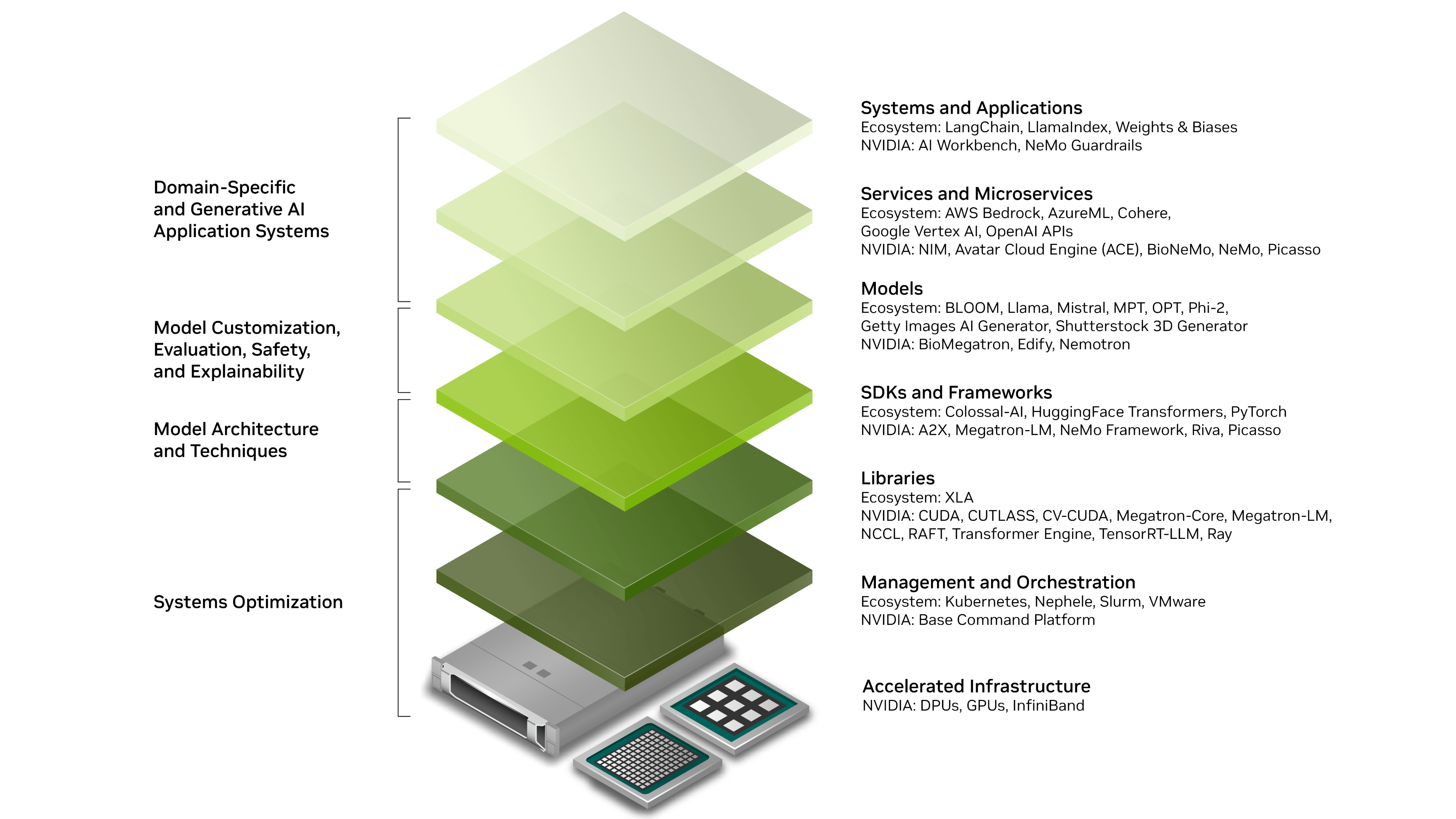

NVIDIA 全栈生成式 AI 软件生态系统

NVIDIA 提供一整套 加速计算平台 专为生成式 AI 工作负载打造该平台兼具深度和广度,提供硬件、软件和服务的组合,所有这些都由 NVIDIA 及其广泛的合作伙伴生态系统构建而成,以便开发者提供尖端解决方案。

为特定用例和领域构建应用程序需要用户友好的 API、高效的微调技术,在 LLM 应用程序的背景下,还需要与稳健的第三方应用程序、向量数据库和护栏系统集成。 NVIDIA 提供 托管的 API 端点和预构建的推理微服务 让开发者能够随时随地部署最新的 AI 模型,从而快速构建自定义生成式 AI 应用。

我们的软件堆栈为 OpenAI、Cohere、Google VertexAI 和 AzureML 等合作伙伴提供支持,使开发者能够使用生成式 AI API 端点。对于特定领域的自定义或使用数据库增强应用程序,除了 NVIDIA NeMo™NVIDIA 的生态系统包括 Hugging Face、LangChain、LlamaIndex 和 Milvus。

为部署安全可靠的模型,NeMo 提供了 简单工具 用于评估经过训练和微调的模型,包括 GPT 和其变体。开发者还可以通过 NeMo 警戒线 控制 LLM 应用程序的输出,例如实施控制以避免讨论政治问题,并根据用户请求定制响应。

MLOps 和 LLMOps 工具可进一步帮助评估 LLM 模型。 NVIDIA NeMo 可与 LLMOps 工具 (如 权重和偏差 和 MLFlow。开发者还可以使用 NVIDIA Triton™ 推理服务器 来分析模型性能和标准化 AI 模型部署。

在计算基础架构上加速特定的生成式 AI 计算需要专门设计的库和编译器,以满足 LLM 的需求。一些非常热门的库包括 XLA、Megatron-LM, CUTLASS, CUDA®, NVIDIA ® TensorRT™-LLM, RAFT 和cuDNN。

构建大规模模型通常需要超过数千个 GPU,而推理则在多节点、多 GPU 配置中进行,以解决内存受限的带宽问题。这需要能够在加速基础设施上精心编排不同的生成式 AI 工作负载的软件。一些管理和编排库包括 Kubernetes、Slurm、Nephele 和 NVIDIA Base Command™.

NVIDIA 加速计算平台为这些应用提供基础架构,以便在数据中心、云端或本地桌面和笔记本电脑上以最经济高效的方式运行。强大的平台和技术包括 NVIDIA DGX™ 平台, NVIDIA HGX™ 系统, NVIDIA RTX™ 系统 和 NVIDIA Jetson™。

使用生成式 AI 构建

开发者可以选择在堆栈的各层与 NVIDIA AI 平台进行交互,从基础设施、软件和模型到应用,可以直接通过 NVIDIA 产品或通过庞大的产品生态系统进行交互。

优势

端到端加速堆栈

借助 DGX 云到 NeMo 的产品,加速堆栈各层,从基础设施层到应用层。

高性能

通过 GPU 优化 (包括量化感知训练、层和张量融合以及内核调整) 提供实时性能。

生态系统集成

与领先的生成式 AI 框架紧密集成。例如, NVIDIA NeMo 的连接器允许在 LangChain 框架中使用 NVIDIA AI 基础模型和 TensorRT-LLM 优化。

访问独家 NVIDIA 资源

通过 NVIDIA 开发者计划,您可以免费访问适用于使用 NVIDIA NIM™ 进行开发的最新 AI 模型,以及访问培训、文档、操作指南、专家论坛、同行和领域专家的支持以及解决最大挑战所需的硬件信息。

与 NVIDIA 专家交流

刚开始使用时有疑问?探索我们的 NVIDIA 开发者论坛,以获取您的问题答案,或者探索其他开发者的见解。

借助 NVIDIA 合作伙伴构建自定义生成式 AI

对于生成式 AI 初创公司而言,NVIDIA 初创加速计划 提供最新的开发者资源、 NVIDIA 软件和硬件的优惠定价,以及与风险投资社区的接触。该计划面向所有阶段的技术初创公司免费提供。

新闻资讯

探索新内容并了解我们的新突破。

共同熠熠生辉:Google 的 Gemma 已经过优化,可在 NVIDIA GPU 上运行

Google 的新型先进、轻量级、20 亿和 70 亿参数的开放语言模型 Gemma 采用 NVIDIA TensorRT-LLM 进行优化,可在任何地方运行,从而降低成本并加快针对特定领域的创新工作。

用于开发物理 AI 的 World Foundation 模型平台

NVIDIA Cosmos™ 是一个先进的 世界基础模型 (WFM) 以及数据管道,加速了物理 AI 实体系统 (如机器人和自动驾驶汽车) 的开发。

Amgen 为新的人类数据见解和药物研发构建生成式 AI 模型

Amgen 是 NVIDIA BioNeMo™ 的早期采用者,使用生成式 AI 模型加速药物研发。他们计划将 NVIDIA DGX SuperPOD™ 集成到训练先进模型的过程中,从而将训练时间从几个月缩短到几天。

开始使用生成式 AI

借助 NVIDIA AI Enterprise 实现企业就绪型生成式 AI

NVIDIA AI Enterprise 订阅包括生产级软件,通过易于部署的微服务、企业支持、安全性和 API 稳定性,将企业推向 AI 前沿。